Σημαντική εξέλιξη που θα μπορούσε να αναδιαμορφώσει το ανταγωνιστικό τοπίο μεταξύ των αμερικανικών τεχνολογικών κολοσσών και των κινεζικών ανταγωνιστών τους

Η κινεζική startup DeepSeek κυκλοφόρησε δύο νέα ισχυρά μοντέλα τεχνητής νοημοσύνης που, σύμφωνα με την εταιρεία, ανταγωνίζονται ή ξεπερνούν τις δυνατότητες του GPT-5 της OpenAI και του Gemini-3.0-Pro της Google.

Αν επιβεβαιωθούν οι ισχυρισμοί αυτοί, θα αποτελούσε μια σημαντική εξέλιξη που θα μπορούσε να αναδιαμορφώσει το ανταγωνιστικό τοπίο μεταξύ των αμερικανικών τεχνολογικών κολοσσών και των κινεζικών ανταγωνιστών τους.

Συγκεκριμένα η εταιρεία με έδρα το Hangzhou παρουσίασε το DeepSeek-V3.2, σχεδιασμένο ως βοηθό καθημερινής λογικής σκέψης, μαζί με το DeepSeek-V3.2-Speciale, μια παραλλαγή υψηλής απόδοσης που πέτυχε επίδοση χρυσού μεταλλίου σε τέσσερις διεθνείς διαγωνισμούς: τη Διεθνή Μαθηματική Ολυμπιάδα 2025, τη Διεθνή Ολυμπιάδα Πληροφορικής, τον Παγκόσμιο Τελικό ICPC και την Κινεζική Μαθηματική Ολυμπιάδα.

🚀 Launching DeepSeek-V3.2 & DeepSeek-V3.2-Speciale — Reasoning-first models built for agents!

🔹 DeepSeek-V3.2: Official successor to V3.2-Exp. Now live on App, Web & API.

🔹 DeepSeek-V3.2-Speciale: Pushing the boundaries of reasoning capabilities. API-only for now.📄 Tech… pic.twitter.com/SC49UdmCZv

— DeepSeek (@deepseek_ai) December 1, 2025

Τα μοντέλα των 685 δισεκατομμυρίων παραμέτρων υποστηρίζουν dialog boxes 128.000 tokens, καθιστώντας τα κατάλληλα για ανάλυση μεγάλων εγγράφων, codebases και ερευνητικών άρθρων.

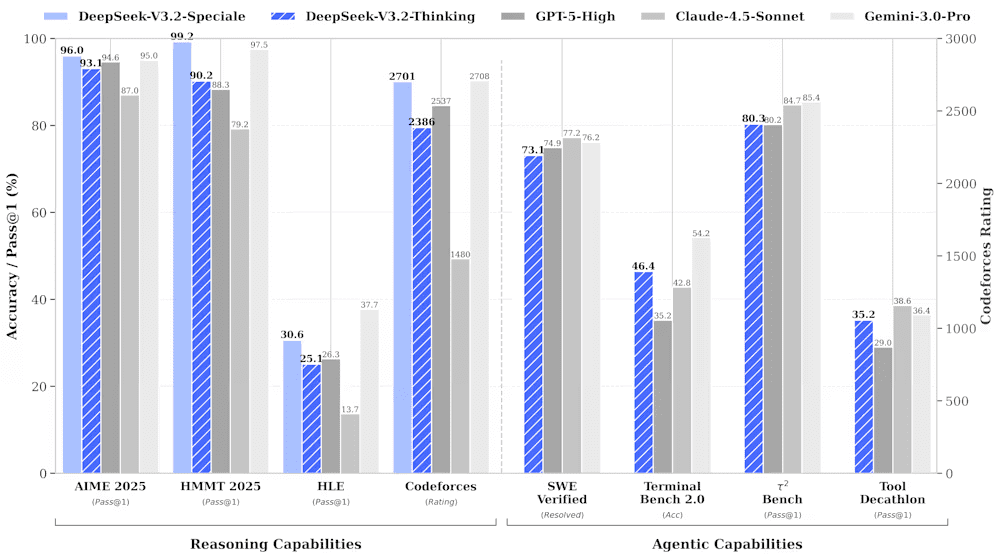

Οι ισχυρισμοί της DeepSeek για ισοτιμία με τα κορυφαία αμερικανικά συστήματα τεχνητής νοημοσύνης βασίζονται σε εκτεταμένες δοκιμές σε μαθηματικά, κωδικοποίηση και εργασίες λογικής σκέψης και μένει να επιβεβαιωθούν το επόμενο διάστημα.

Στο AIME 2025, έναν διάσημο αμερικανικό μαθηματικό διαγωνισμό, το DeepSeek-V3.2-Speciale πέτυχε ποσοστό επιτυχίας 96,0%, σε σύγκριση με 94,6% για το GPT-5-High και 95,0% για το Gemini-3.0-Pro. Στο Harvard-MIT Mathematics Tournament, η παραλλαγή Speciale σκόραρε 99,2%, ξεπερνώντας το 97,5% του Gemini.

Το τυπικό μοντέλο V3.2, βελτιστοποιημένο για καθημερινή χρήση, σκόραρε 93,1% στο AIME και 92,5% στο HMMT — ελαφρώς χαμηλότερα από τα πρωτοποριακά μοντέλα αλλά επιτεύχθηκε με σημαντικά λιγότερους υπολογιστικούς πόρους.

Το DeepSeek-V3.2-Speciale σκόραρε 35 από 42 βαθμούς στη Διεθνή Μαθηματική Ολυμπιάδα 2025, κερδίζοντας το χρυσό μετάλλιο. Στη Διεθνή Ολυμπιάδα Πληροφορικής, σκόραρε 492 από 600 βαθμούς — επίσης χρυσό, καταλαμβάνοντας τη 10η θέση συνολικά. Το μοντέλο έλυσε 10 από 12 προβλήματα στον Παγκόσμιο Τελικό ICPC, τερματίζοντας δεύτερο.

Αντίθετα με την OpenAI και την Anthropic, που φυλάσσουν τα ισχυρότερα μοντέλα τους ως ιδιόκτητα περιουσιακά στοιχεία, η DeepSeek κυκλοφόρησε και τα δύο μοντέλα V3.2 και V3.2-Speciale υπό την άδεια MIT — ένα από τα πιο “ελεύθερα” πλαίσια ανοιχτού κώδικα που υπάρχουν.

Οποιοσδήποτε προγραμματιστής, ερευνητής ή εταιρεία μπορεί να κατεβάσει, να τροποποιήσει και να αναπτύξει τα μοντέλα των 685 δισεκατομμυρίων παραμέτρων χωρίς περιορισμούς. Όλα τα νέα μοντέλα της Deepseek μαζί με την απαραίτητη τεκμηρίωση είναι διαθέσιμα στο Hugging Face, την κορυφαία πλατφόρμα για κοινή χρήση μοντέλων τεχνητής νοημοσύνης.

ΕΙΔΗΣΕΙΣ ΣΗΜΕΡΑ:

- Η AKTOR συζητά με Πειραιώς, ΕΤΒΑ ΒΙΠΕ και Υπερταμείο για να πει στο Θριάσιο Εμπορευματικό Κέντρο

- ΣΩΛΗΝΟΥΡΓΕΙΑ ΤΖΙΡΑΚΙΑΝ ΠΡΟΦΙΛ Α.Ε. - ΑΝΑΚΟΙΝΩΣΗ ΡΥΘΜΙΖΟΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΑΣ – ΓΝΩΣΤΟΠΟΙΗΣΗ ΣΥΝΑΛΛΑΓΩΝ

- Aλλαγές στη Διοικητική Ομάδα του Ομίλου Μοτοδυναμική

- ΣΩΛΗΝΟΥΡΓΕΙΑ ΤΖΙΡΑΚΙΑΝ ΠΡΟΦΙΛ Α.Ε. - ΓΝΩΣΤΟΠΟΙΗΣΗ ΜΕΤΑΒΟΛΗΣ ΠΟΣΟΣΤΟΥ ΔΙΚΑΙΩΜΑΤΩΝ ΨΗΦΟΥ >=5%

- Ευρωπαϊκές αγορές: Έκλεισαν με απώλειες, παρά την ανάκαμψη των πολύτιμων μετάλλων

- Intracom: Συμμετοχή θυγατρικής στις αυξήσεις κεφαλαίου των Regency και Athens Resort Casino

- Ρέι Ντάλιο: Ο κόσμος βρίσκεται «στο χείλος» ενός πολέμου κεφαλαίων – Κορυφαίο «καταφύγιο» ο χρυσός

- Δομική Κρήτης: Υπέγραψε σύμβαση 9,19 εκατ. ευρώ για επέκταση του λιμένα στην Ίο

Ακολουθήστε το financialreport.gr στο Google News και μάθετε πρώτοι όλες τις ειδήσεις